本記事では、データを集めて分析し、業務改善や問題解決に役立てるための考え方を整理します。データの種類や前処理、統計情報の読み方、バイアスへの注意点、さらにデータサイエンスやビッグデータ活用までを、章ごとに分けてわかりやすく解説していきます。

1. データ利活用の全体像

この章では、データ利活用の全体像をつかみます。データを集めて分析し、業務改善や意思決定に活かすまでの流れと、そこで重要になる「前処理」や「ドメイン知識」の役割を整理しておきましょう。

データ利活用とは

データ利活用とは、データを集めて整理・分析し、その結果を業務改善や新サービスの企画などに役立てることです。単にデータを集めるだけでなく、「どんな課題を解決したいのか」「そのためにどんなデータが必要なのか」を考えて活用していく姿勢が求められます。

データ利活用がうまくいくと、勘や経験だけに頼らず、根拠のある意思決定がしやすくなります。また、社内のさまざまな部署で共通の数字を見ながら話し合えるようになるため、コミュニケーションもスムーズになります。

データ分析と業務改善

データ分析は目的ではなく手段です。売上を伸ばしたい、コストを下げたい、品質を安定させたいなど、最初に業務上の課題を明確にしておくことで、必要なデータや分析方法が見えてきます。

分析結果は、改善の「仮説」を立てる材料になります。仮説に基づいて施策を実行し、再度データを集めて効果を検証することで、改善のサイクルを回すことができます。この循環を途切れさせず続けることが、データ利活用を定着させるポイントです。

データの前処理の重要性

どれだけ高度な分析手法を使っても、元のデータが汚れていれば信頼できる結論は得られません。入力ミスや欠損値、重複レコードなどを整理する前処理(データクレンジング)は、地味ですが非常に重要な工程です。

前処理がしっかり行われていると、分析の再現性が高まり、他の人が同じデータを使っても同じ結論を得やすくなります。逆に前処理を省略すると、後から誤りに気づいてやり直しになることも多く、結果的に大きな時間のロスにつながります。

ドメイン知識の役割

ドメイン知識とは、扱うデータが属する業界や専門分野に関する知識のことです。データの意味や背景を理解し、数字の裏にある現場の状況をイメージするために欠かせません。

同じ数字でも、業界の慣習や制度を知らないと解釈を誤ることがあります。例えば、医療データや金融データなどは、専門的なルールや用語を理解したうえでないと正しい分析が難しい分野です。データサイエンティストと現場担当者が協力し合うことが重要になります。

データ発生現場の確認

データは、実際の業務や現場から発生しています。どのようなタイミングで、誰が、どんなシステムに入力しているのかを確認すると、データのクセや限界が見えてきます。

例えば、忙しい時間帯には入力が後回しになりがちであったり、ある部署だけ特別なルールで入力していたりすることがあります。こうした事情を知らずに数字だけを見て判断すると、誤った結論につながることがあります。現場の状況を理解することは、統計的な知識と同じくらい大切です。

2. データの種類を整理して理解する

この章では、データ利活用の対象となるさまざまな種類のデータを整理します。どのデータも一見似て見えますが、特徴や向いている分析が異なります。種類ごとのイメージを持っておくと、どの場面で何を使えば良いか判断しやすくなります。

データを集める目的

データを集める際には、「集められるものをとりあえず全部集める」のではなく、「何のために集めるのか」をはっきりさせておく必要があります。例えば、顧客の離反を防ぎたいのか、在庫を減らしたいのかによって、必要なデータは大きく変わります。

目的が明確であれば、どの項目は必須で、どの項目は後回しにできるかを判断しやすくなります。その結果、不要なデータを減らし、入力負担や保管コストを抑えつつ、必要な情報はきちんと取れる仕組みを設計しやすくなります。

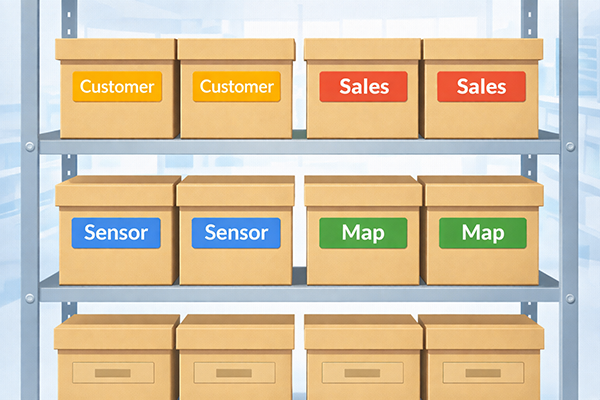

顧客データ

顧客データは、顧客の属性や購買履歴、問い合わせ履歴などをまとめたものです。BtoCの場合は年齢・性別・住所・購入商品など、BtoBの場合は業種・規模・担当部署などが代表的な項目です。

このデータを活用することで、優良顧客の特徴を分析したり、特定のセグメント向けにキャンペーンを設計したりできます。一方で、個人情報の塊でもあるため、取り扱いには十分な注意とルール整備が必要です。

実績データ

実績データは、売上・仕入・生産量・在庫量など、企業活動の結果が数値として記録されたデータです。会計システムや販売管理システムに蓄積されていることが多く、多くの分析の基礎となります。

実績データを見れば、過去のトレンドや季節性、事業の成長度合いなどを把握できます。また、顧客データや商品データと組み合わせることで、「どの顧客が、どの商品を、どのくらいの頻度で買っているか」といった分析も可能になります。

人の行動ログデータ

人の行動ログデータは、Webサイトの閲覧履歴、アプリの操作履歴、店舗での動線など、人の行動を時系列で記録したデータです。アクセス解析ツールやアプリ内のログ収集機能などで取得されます。

このデータからは、ユーザーがどの画面で離脱しやすいか、どの順番でページを見ているかといった行動パターンが読み取れます。UIの改善や、レコメンドの最適化など、体験向上のための貴重な材料になります。

機械の稼働ログデータ

機械の稼働ログデータは、工場設備やIoT機器から出力される、稼働状況や温度・振動などのセンサー情報です。一定間隔で自動的に記録されるため、膨大な量のデータになることが特徴です。

このデータを分析すると、故障の予兆を検知してメンテナンスを前倒ししたり、稼働パターンから無駄な待ち時間を特定したりできます。人の手では気づきにくい細かな変化を捉えられる点が大きなメリットです。

GISデータ

GISデータは、地図と結び付いた位置情報のデータです。店舗や施設の位置、顧客の住所、交通網や行政区分などが含まれます。地理情報システム(GIS)で扱われることが多いデータです。

GISデータを使うと、売上や人口などを地図上に色分けして表示できるため、どの地域が強いのか、どこにポテンシャルがあるのかを直感的に把握できます。出店計画や配送ルートの最適化など、さまざまな業務で役立ちます。

量的データ

量的データは、数値として測定できるデータです。売上金額、温度、身長、アクセス数などが代表例で、足し算や平均値の計算が可能です。折れ線グラフや散布図など、多くのグラフで扱いやすいデータとも言えます。

量的データは、統計分析の中心的な対象です。ただし、測定方法や単位、丸め方などによって意味が変わる場合があるため、収集方法を確認しながら扱う必要があります。

質的データ

質的データは、数値ではなくカテゴリやラベルで表されるデータです。性別、職業、商品カテゴリ、アンケートの選択肢などが典型的な例です。量的データのような足し算はできませんが、割合や構成比などで分析することができます。

質的データをグラフ化するときは、棒グラフや円グラフ、モザイク図などがよく使われます。量的データと組み合わせて、「属性による違い」を把握する際にも重要な役割を果たします。

1次データ

1次データは、自社が直接調査・観測して集めたデータです。独自アンケートや実験、センサーからの生データなどが該当します。調査目的に合わせて項目を設計できるため、ニーズに合った情報を取りやすい点がメリットです。

一方で、調査の設計や実施にコストと時間がかかるというデメリットもあります。どの範囲を1次データで集め、どこから先は既存データを利用するかの見極めが重要になります。

2次データ

2次データは、他の組織がすでに集めて公開しているデータを利用したものです。政府統計、業界団体の資料、オープンデータなどが代表例です。低コストで幅広い情報を入手できる点が魅力です。

ただし、目的が自社のニーズと完全には一致しない場合も多く、定義や集計方法を理解して使う必要があります。2次データをそのまま鵜呑みにせず、どの範囲まで当てはめてよいかを慎重に判断することが大切です。

メタデータ

メタデータは、「データに関するデータ」です。データがいつ、どこで、どのようにして取得されたのか、どのような単位なのか、といった情報がこれに当たります。

メタデータがしっかり整備されていると、時間がたってからデータを見返したときでも意味を正しく理解できます。逆にメタデータがないと、「この数字は何の単位だったか」「どの期間のデータだったか」といった基本的なことから調べ直さなければならなくなります。

構造化データ

構造化データは、行と列の形に整理された表形式のデータです。データベースや表計算ソフトで扱いやすく、検索や集計も容易に行えます。売上明細や顧客マスタなど、多くの業務データが構造化データとして保管されています。

構造化データは、決まった項目と型があるため、分析や可視化にすぐ使える点が強みです。一方で、自由な文章や画像といった情報は、そのままでは構造化データには収まりません。

非構造化データ

非構造化データは、文章・画像・音声・動画など、一定の枠組みに収まりにくいデータです。メール本文、SNS投稿、写真、録音データなどがこれに該当します。

非構造化データには、人の本音や状況が豊かに含まれていますが、そのままでは分析が難しいという特徴があります。自然言語処理や画像処理などの技術を使って特徴を抽出し、構造化データに近い形に変換してから活用するケースが増えています。

時系列データ

時系列データは、時間の経過に沿って同じ指標を継続的に記録したデータです。日次売上、毎時の温度、1分ごとのアクセス数などが代表的です。折れ線グラフにすると、トレンドや季節性が見えやすくなります。

時系列データは、将来の予測や、変化点の検知などに用いられます。季節調整や移動平均といった前処理を行うことで、長期的な傾向をより分かりやすくすることもよく行われます。

クロスセクションデータ

クロスセクションデータは、ある時点における複数の対象の状態を並べたデータです。ある日付の時点での都道府県別人口や、アンケート調査で集めた回答者ごとの属性情報などが該当します。

クロスセクションデータは、「地域間の違い」「属性別の違い」といった横方向の比較に向いています。時系列データと組み合わせることで、「時間の変化」と「対象間の違い」の両方を分析することもできます。

3. 前処理と分析を支える技術

この章では、データを分析に使える状態に整える前処理と、その周辺の技術を取り上げます。前処理は目立ちませんが、分析の信頼性を支える縁の下の力持ちです。

データの簡単な前処理

前処理の第一歩は、形式や単位をそろえることです。日付の表記がバラバラだったり、売上が円と千円で混在していたりすると、そのままでは計算ができません。まずはフォーマットを統一し、不要な空白や記号を取り除いていきます。

次に、項目名を分かりやすく整えたり、意味の重複している列を統合したりします。こうした作業を通じて、「誰が見ても何が書いてあるか分かるデータ」に近づけていきます。

機械判読可能なデータの作成

機械判読可能なデータとは、コンピュータが自動処理しやすい形に整えられたデータです。PDFの中の画像だけで保存された表よりも、CSVやデータベースの形式で保存された表のほうが、機械判読には向いています。

手書きの書類や紙の帳票をスキャンして画像にするだけでは、まだ機械判読とは言えません。OCRなどを使って文字データに変換し、項目ごとに区切られた形式にすることで、初めてプログラムから扱いやすい状態になります。

データの記録方法

データの記録方法によって、後からどのような分析ができるかが変わります。例えば、日単位の売上しか記録していない場合、時間帯別の分析はできません。一方で、あまり細かく記録しすぎると、データ量が膨大になり保管や処理が大変になります。

どの粒度で、どの項目を記録するかは、目的とコストのバランスを見ながら決める必要があります。記録方法を見直すこと自体が、データ利活用の重要な改善テーマになります。

データのサンプリング

データのサンプリングは、全体の一部を取り出して分析することです。データ量が非常に多い場合、全件を処理すると時間やメモリが足りないことがあります。そのようなとき、代表性のあるサンプルを使って試しに分析し、方針を検討することがあります。

サンプリングでは、「どのような基準で抽出したか」を明確にしておくことが重要です。特定の期間や特定の顧客だけに偏ったサンプルを使うと、全体像と違う結論になってしまうので注意が必要です。

データの名寄せ

データの名寄せは、同じ顧客や企業が、表記ゆれや入力ミスによって別人のように登録されている場合に、それらを一つに統合する作業です。例えば、「株式会社〇〇」「(株)〇〇」「㈱〇〇」などを同じ企業と見なしてまとめます。

名寄せを行うことで、顧客ごとの取引状況を正しく把握できるようになります。重複登録を減らすことで、メール配信やDM送付のムダを減らすといった効果も期待できます。

外れ値の処理

外れ値は、他のデータと比べて極端に大きい、または小さい値のことです。単純な入力ミスの場合もあれば、実際に異常事態が起きた結果である場合もあります。

外れ値の扱いを誤ると、平均値や回帰分析の結果が大きく歪んでしまいます。そのため、外れ値を見つけたら、まず原因を確認し、明らかな誤りであれば修正・削除する、意味のある値であれば別扱いで分析するといった判断が必要になります。

異常値の処理

異常値は、業務の想定範囲から外れている値や、システムの仕様上あり得ない値を指します。例えば、在庫数がマイナスになっている場合や、日付が存在しない日になっている場合などがこれに当たります。

異常値は、そのまま分析に使うと誤った結論を導く原因になります。入力ロジックの修正や、チェック機能の追加など、データの流れそのものを見直すきっかけとしても重要なサインです。

欠損値の処理

欠損値は、本来あるはずのデータが記録されていない状態です。アンケートの未回答や、システム障害によるデータ欠落など、理由はさまざまです。

欠損値が多い項目は、分析から除外せざるを得ないこともあります。少数の欠損であれば、平均値や近い値で補完する方法もありますが、補完したことを忘れてしまうと誤解のもとになります。どの方法を採ったのかを記録しておくことが大切です。

アノテーション

アノテーションは、データに意味づけをする作業です。画像に「ここが傷」「ここが製品」といったラベルを付けたり、文章に「ポジティブ」「ネガティブ」といった感情ラベルを付けたりするケースが代表的です。

アノテーションは、機械学習でモデルを訓練する際の教師データとして使われます。ラベル付けの基準があいまいだと、学習結果も不安定になるため、わかりやすいルールを決めて作業することが重要です。

データの季節調整

データの季節調整は、月次や四半期の売上など、季節による規則的な変動を取り除いて、基調的なトレンドを把握しやすくするための処理です。例えば、12月だけ売上が増えるのは季節要因であり、長期的な成長とは分けて考える必要があります。

季節調整を行うことで、「実際に基礎的な力が伸びているのか、それとも季節要因だけなのか」を判断しやすくなります。景気動向の分析などでも、よく用いられる手法です。

データの移動平均

移動平均は、一定期間の平均値を順番に計算して、短期的なブレをならし、全体の傾向を見えやすくする方法です。例えば、直近7日間の平均値を毎日計算すると、日ごとのバラつきは減り、滑らかな線になります。

移動平均を使うと、急な上下動に惑わされずに、増加傾向なのか減少傾向なのかを冷静に判断できます。ただし、平均を取ることで一時的なピークが見えにくくなる場合もあるため、元データとの見比べも大切です。

自然言語処理

自然言語処理は、人間の言葉(自然言語)をコンピュータで扱う技術です。文章を単語に分割したり、品詞を判定したり、意味の似ている文を見つけたりといった処理が含まれます。

アンケートの自由記述やSNSの投稿、問い合わせメールなどを分析する際には、自然言語処理が欠かせません。テキストを数値化して扱えるようにすることで、集計やクラスタリング、感情分析など、さまざまな分析が可能になります。

画像処理

画像処理は、写真や動画から特徴を抽出したり、ノイズを除去したりする技術です。製造業の外観検査や、顔認識、医療画像の解析など、幅広い場面で利用されています。

画像データをデータ利活用の対象とするには、画像処理でひび・傷・形状などの特徴量を数値として取り出すことが重要です。これにより、画像も他の数値データと同じように、統計分析や機械学習の対象として扱えるようになります。

4. 統計情報の読み方とバイアスへの注意

この章では、統計情報を使ってデータを読み解く際の基本用語と、バイアスや誤解に注意するポイントをまとめます。数字やグラフを見る力を身につけることは、データ利活用を進めるうえで欠かせません。

データから言えることの整理

統計情報を扱うときは、「データから言えること」と「データからは言えないこと」を区別する必要があります。例えば、あるクーポン施策の後に売上が増えたとしても、それだけでは必ずしも施策の効果とは言い切れません。

他の要因(季節、競合の動き、価格変更など)が影響している可能性を考えながら、結論を慎重に組み立てることが重要です。統計はあくまで材料であり、解釈は人が責任を持って行う必要があります。

母集団

母集団は、分析の対象となる全体の集合です。「国内のすべての世帯」「ある金融商品の全契約者」など、どこまでを対象にするかを最初に決める必要があります。

母集団の定義があいまいだと、調査結果をどこまで一般化してよいか判断できません。まず「誰についての話をしているのか」を明確にすることが、統計情報を読み解く第一歩です。

標本抽出

標本抽出は、母集団の一部を選んで調査することです。現実には全員を調査するのが難しい場面が多いため、標本を使って母集団の性質を推測します。

標本抽出を行う際には、偏りなく抽出できているかどうかが重要です。偏りがあると、どれだけ精密に計算しても正しい結論には近づきません。抽出方法の妥当性を確認する視点が求められます。

国勢調査

国勢調査は、日本国内に住むすべての人と世帯を対象に行われる、典型的な全数調査です。5年ごとに実施され、人口構成や就業状況など、さまざまな統計の基礎として使われています。

国勢調査のような全数調査は、サンプル調査と比べて精度が高い反面、実施の手間やコストが非常に大きくなります。そのため、頻繁には行えず、他の統計調査と組み合わせて利用されます。

アンケート調査

アンケート調査は、標本抽出した対象に対して質問票を配布し、回答を集める調査方法です。インターネット調査や郵送調査、街頭調査など、さまざまな形式があります。

アンケート調査では、質問の仕方や選択肢の作り方によって結果が変わることがあります。回答しやすさと正確さのバランスを考えながら設計することが重要です。

全数調査

全数調査は、母集団の全員を調査する方法です。国勢調査や、社員全員を対象にした社内アンケートなどが代表例です。標本誤差がないため、母集団の状態を正確に把握できる点がメリットです。

一方で、コストや時間の制約から、頻繁に実施するのは難しい方法でもあります。どの調査を全数調査にするかは、重要度や実現可能性を踏まえて選ぶ必要があります。

単純無作為抽出

単純無作為抽出は、母集団の中からランダムに標本を選ぶ方法です。全員が同じ確率で選ばれるため、理論上は偏りの少ない標本を得やすい方法だと言えます。

ただし、実務では名簿が不完全だったり、ランダム抽出の手段に制約があったりするため、理想どおりにいかないこともあります。実際にどのように抽出したのかを確認することが大切です。

層別抽出

層別抽出は、母集団を性別や年代、地域などの層に分け、それぞれの層からバランスよく標本を選ぶ方法です。重要な属性ごとに、一定数のサンプルを確保したい場合に有効です。

例えば、高齢者の意見も若者の意見も同じくらいの重みで把握したいときには、年代ごとに同じサンプル数を取る層別抽出が向いています。その分、集計時には重み付けが必要になる場合もあります。

多段抽出

多段抽出は、複数の段階に分けて標本を選ぶ方法です。まず市区町村を選び、その中から調査対象となる地区を選び、さらに世帯を選ぶ、といった手順で抽出します。

広い範囲を効率よく調査したいときに利用されますが、各段階で偏りが入らないように注意が必要です。設計が複雑になるため、調査方法の説明をよく読んで理解することが大切です。

仮説検定

仮説検定は、母集団についての仮説が正しいかどうかを、標本データを使って検証する方法です。例えば、「新しい広告の導入前後で売上に差があるかどうか」を判断する場面が該当します。

仮説検定では、まず「差がない」という帰無仮説を立て、その仮説を前提としたときに、観測結果がどれくらい起こりやすいかを計算します。起こりにくいと判断された場合、帰無仮説を棄却し、「差がある」と結論づけます。

有意水準

有意水準は、「どの程度起こりにくければ、偶然ではないと判断するか」を示す基準です。代表的な値として5%や1%が使われ、例えば有意水準5%なら「偶然に起こる確率が5%未満であれば差があるとみなす」というルールになります。

有意水準は低いほど慎重な判断になりますが、そのぶん「差があるのに見逃す」可能性が高まります。どのレベルで設定するかは、誤判定の影響度を考えながら決める必要があります。

第1種の誤り

第1種の誤りは、本当は差がないのに「差がある」と誤って判断してしまうことです。例えば、効き目のない薬を「効く」と誤判定してしまうようなケースがこれに当たります。

この誤りは、ときに重大な結果を招くことがあります。そのため、医療や安全に関わる分野では、第1種の誤りを極力小さくするような検定設計が求められます。

第2種の誤り

第2種の誤りは、本当は差があるのに「差がない」と誤って判断してしまうことです。効き目のある薬を「効かない」と判断してしまうケースが典型例です。

第2種の誤りが多いと、有効な改善策を見逃すことになります。第1種の誤りとのバランスを取りながら、どの程度のリスクを許容するかを検討することが必要です。

精度

精度は、測定値や推定値のばらつきの小ささを表します。同じ条件で繰り返し測定したとき、結果がほとんど変わらなければ精度が高いと言えます。

精度が低いと、グラフがギザギザになり、トレンドが読み取りにくくなります。測定方法やサンプルサイズの見直しによって、精度を上げる努力が求められます。

統計的バイアス

統計的バイアスは、データの集め方や処理の仕方によって生じる体系的な偏りです。平均値からの誤差が偶然に左右されるのとは異なり、特定の方向へ一方的にズレるのが特徴です。

バイアスが大きいと、どれだけサンプルサイズを増やしても真の値には近づきません。調査設計の段階で、バイアスをできるだけ小さくする工夫が重要になります。

選択バイアス

選択バイアスは、調査対象の選び方が偏っているために、結果が母集団を正しく反映しない状態です。例えば、インターネット調査だけで高齢者の意見を推測しようとすると、ネットを利用しない人々が抜け落ちることになります。

選択バイアスを避けるには、標本抽出方法を工夫したり、調査のカバー範囲を補うデータを組み合わせたりする必要があります。結果だけでなく、「誰から集めたデータか」を確認する癖を付けると良いでしょう。

情報バイアス

情報バイアスは、情報の取得方法や記録方法の違いによって生じる偏りです。自己申告による体重や飲酒量などは、実際より少なめに報告される傾向があるかもしれません。

情報バイアスに注意するには、測定方法を統一したり、客観的な指標を可能な限り利用したりすることが求められます。調査票の設計やインタビューの仕方も重要なポイントになります。

認知バイアス

認知バイアスは、人間の思考のクセによる判断の偏りです。自分の考えを裏付ける情報だけを集めてしまう「確証バイアス」や、最近見聞きした例を過大評価してしまう「利用可能性ヒューリスティック」などが代表例です。

データ分析を行う人も人間である以上、認知バイアスから自由ではありません。自分に都合の良い結論に飛びつかず、反対の結果を示すデータがないかも確認する姿勢が大切です。

各代表値の性質の違い

代表値には、平均値・中央値・最頻値などがあります。それぞれ長所と短所が異なり、データの性質によって適切な代表値は変わります。平均値は全体のバランスを表しますが、外れ値の影響を強く受けます。

中央値は、データを大小順に並べたときの真ん中の値で、外れ値の影響を受けにくいのが特徴です。給与水準など、極端な高所得者がいる場合には、中央値のほうが「一般的な人」の感覚に近いことが多くなります。統計情報を見るときには、「どの代表値が使われているか」を意識することが大切です。

統計情報の誤表現に惑わされない理解

統計情報は、グラフの作り方や数字の切り取り方によって印象が大きく変わります。縦軸のスケールを途中から切ると差が極端に見えたり、割合だけを示して分母の大きさを隠したりするケースもあります。

情報を受け取る側としては、「サンプル数」「縦軸の範囲」「調査方法」などを確認し、誇張された表現に惑わされないようにする必要があります。数字を信じることと、数字にだまされないことの両方が、統計リテラシーとして求められます。

文献や現象を読み解き関係を考察する姿勢

統計データだけでなく、文献や現場の観察結果も重要な情報源です。複数の資料を読み比べ、その共通点と相違点を整理することで、より深い理解に到達できます。

データだけを眺めるのではなく、「なぜこの数字になっているのか」「過去の研究ではどう説明されているのか」を考える癖を付けると、分析の質が大きく向上します。統計は、現実世界の理解を助ける道具であることを意識しておくとよいでしょう。

5. データサイエンスとビッグデータ活用

この章では、データサイエンスやビッグデータ分析に関するキーワードを整理します。大量のデータを扱う際の考え方や、活用の際に意識すべきポイントを確認しておきましょう。

データサイエンス

データサイエンスは、統計学や機械学習、プログラミング、ビジネス理解などを組み合わせて、データから価値を生み出す学問・実務の領域です。単に分析を行うだけでなく、課題設定から結果の説明、施策の提案までを含めて考える点が特徴です。

データサイエンスの目的は「数字をきれいにまとめること」ではなく、「なぜそうなっているのか」「次に何をすべきか」を明らかにすることです。そのためには、統計的な手法と同じくらい、ドメイン知識やコミュニケーション能力も重要になります。

ビッグデータ分析

ビッグデータ分析は、大量・高速・多様なデータから有用な知見を取り出す取り組みです。アクセスログやセンサー情報、SNS投稿、動画など、従来の技術では扱いきれなかったデータも対象になります。

ビッグデータ分析では、個々のデータポイントよりも、全体としてのパターンや傾向、異常値の発見などに重点が置かれます。分散処理基盤やクラウド環境を活用して、大規模な計算を効率よく行うことが一般的です。

BI(Business Intelligence)

BI(Business Intelligence)は、企業内のデータを集約・可視化し、経営判断や業務改善に役立てる仕組みやツールです。ダッシュボードやレポート機能を通じて、現場から経営層までが共通の数字をリアルタイムで確認できるようにします。

BIツールを使えば、専門的なプログラミングを行わなくても、担当者が自らグラフを作成したり、簡単な分析を行ったりできます。日々の業務でデータを活用するための入り口として、非常に重要な役割を担っています。

データウェアハウス

データウェアハウスは、企業内のさまざまなシステムからデータを集めて蓄積し、分析しやすい形式に整えたデータベースです。販売、在庫、会計、顧客など、元々は別々のシステムにあった情報を一か所に集約します。

これにより、「商品別・地域別・期間別の売上」など、複数システムにまたがる分析が容易になります。BIツールやデータマイニングの基盤として利用されることが多く、データ利活用のインフラと言える存在です。

データマイニング

データマイニングは、大量のデータから統計・機械学習・パターン認識などの技術を使って有用なルールやパターンを見つけ出す手法です。購買履歴から一緒に買われやすい商品を発見するマーケットバスケット分析などが代表的な例です。

見つかったパターンは、レコメンドシステムやキャンペーン設計、在庫最適化など、さまざまな業務に活かすことができます。ただし、相関関係を過度に拡大解釈しないよう、統計的な検証やドメイン知識を踏まえた判断も重要です。

ビッグデータ

ビッグデータは、従来のデータベース技術では扱いきれないほどの「量」「速度」「多様性」を持つデータの総称です。例えば、センサーが1秒ごとに出力するログや、世界中から送られてくるSNS投稿、動画・画像データなどがこれに当たります。

ビッグデータは、適切に活用すれば、新しいサービスやビジネスモデルを生み出す可能性を秘めています。一方で、保存や処理のコスト、プライバシー保護、セキュリティ確保など、多くの課題も抱えています。

テキストマイニング

テキストマイニングは、文章データを対象としたデータマイニングです。自然言語処理を用いて文章からキーワードを抽出し、出現頻度や共起関係、感情の傾向などを分析します。

商品レビューやアンケートの自由記述、SNSの投稿などを対象にすると、顧客の本音や潜在的なニーズ、不満点を把握することができます。定量アンケートだけでは見えない部分を補う手法として、重要性が増しています。

データサイエンスのサイクル

データサイエンスのサイクルは、課題設定、データ収集、前処理、分析・モデル構築、評価、業務への適用という一連の流れを指します。どこか一つだけを行うのではなく、このサイクルを何度も回しながら改善していくことが重要です。

実務では、最初の課題設定が曖昧だと、いくら高度な分析をしても成果に結びつかないことがあります。サイクル全体を意識し、「次にどのステップに進むか」を常に考えながら進めることが求められます。

データサイエンティスト

データサイエンティストは、統計や機械学習の知識だけでなく、ビジネス理解やコミュニケーション能力を持ち、データから価値を引き出す役割を担う人材です。分析の手法を選ぶだけでなく、関係者と議論しながら課題を整理し、結果を分かりやすく説明することも仕事の一部です。

1人で何もかもできる「万能の人」を目指す必要はありませんが、データとビジネスの橋渡し役として、チームの中心で動ける人材がデータサイエンティストだと考えるとイメージしやすいでしょう。

オープンデータ

オープンデータは、誰でも自由に利用・再利用・再配布できる形で公開されたデータです。政府や自治体、国際機関などが提供する統計や地理情報、交通情報などが代表例です。

オープンデータを活用すると、低コストでさまざまな分析が可能になります。自社データと組み合わせれば、エリア分析や人口動態の考慮、他地域との比較など、多彩な切り口での検討が行えます。

パーソナルデータ

パーソナルデータは、個人に関する情報で、氏名や住所、メールアドレス、位置情報、購買履歴などが含まれます。本人が特定できる情報かどうか、本人の同意を得ているかどうかが重要なポイントになります。

パーソナルデータを活用することで、個々のニーズに合わせたサービス提供が可能になりますが、同時にプライバシーやセキュリティに十分配慮する必要があります。匿名化やアクセス権限の管理など、法令とガイドラインに沿った運用が求められます。

その他のビッグデータの分類

ビッグデータには、オープンデータやパーソナルデータのほか、企業内部で蓄積される業務データや、センサーから集まる機械データ、SNSなどのソーシャルデータなど、さまざまな種類があります。それぞれに特有の利点とリスクが存在します。

どのデータをどの目的で利用するかを整理し、必要に応じて複数のデータを組み合わせることで、より深い洞察が得られます。データの性質を理解したうえで、最適な組み合わせを考えることが重要です。

ビッグデータ活用の留意点

ビッグデータ活用では、データの品質や偏り、プライバシー・セキュリティ、説明可能性など、多くの点に注意が必要です。量が多いからといって、自動的に正しい結論が得られるわけではありません。

特に、パーソナルデータの扱いでは、本人の同意や利用目的の明確化、第三者提供の制限など、法令やガイドラインを守ることが欠かせません。技術的な観点だけでなく、倫理的・法的な観点も含めて検討することが大切です。

ビッグデータ活用の課題

ビッグデータ活用には、システム投資や人材育成、組織文化の変革など、多くの課題があります。データがサイロ化されていて部門間で共有しにくい、分析結果を業務に反映する仕組みがない、といった組織的な問題もよく見られます。

これらの課題を乗り越えるには、経営レベルでの方針と現場の協力が必要です。小さな成功事例を積み重ねながら、データ利活用の価値を組織全体で共有していくことが、長期的な定着につながります。

まとめ

データ利活用を進めるうえでは、まずデータの種類を整理して理解することが重要です。顧客データや実績データ、行動ログ、機械の稼働ログ、GISデータなど、それぞれの特徴を把握し、量的データと質的データ、1次データと2次データ、構造化データと非構造化データ、時系列データとクロスセクションデータといった区分を意識しておくと、目的に合ったデータ選びがしやすくなります。

次に、サンプリングや名寄せ、外れ値・異常値・欠損値の処理、アノテーション、季節調整、移動平均、自然言語処理、画像処理といった前処理の技術は、分析の信頼性を支える重要な基盤です。母集団や標本抽出、仮説検定、有意水準、第1種・第2種の誤り、精度、統計的バイアス、認知バイアス、代表値の性質などの概念を理解し、統計情報の誤った表現に惑わされない姿勢を身につけることで、数字をより正しく読み解けるようになります。

さらに、BIやデータウェアハウス、データマイニング、テキストマイニング、データサイエンスのサイクル、データサイエンティスト、ビッグデータ、オープンデータ、パーソナルデータといったキーワードを押さえておくと、データサイエンスとビッグデータ活用の全体像が見えてきます。技術的な手法やツールだけでなく、ドメイン知識やプライバシーへの配慮、組織としての取り組み方までを含めて考えながら、データを業務改善や新たな価値創造につなげていくことが、これからの時代に求められるデータ利活用の姿だと言えるでしょう。

コメント